习近平总书记指出,“加快发展新一代人工智能是我们赢得全球科技竞争主动权的重要战略抓手,是推动我国科技跨越发展、产业优化升级、生产力整体跃升的重要战略资源”。在共同促进全球人工智能健康、有序、安全发展的过程中,学习全球主要经济体发展和监管人工智能产业的有益经验,有助于我国更好把握产业发展大势,提升治理水平。欧洲议会、欧盟委员会和27个成员国代表在36个小时艰难谈判之后,就欧盟《人工智能法案》(以下简称《法案》)达成里程碑式协议。其中,平衡发展与监管是谈判的焦点,形成的部分成果值得参考借鉴。

欧盟《人工智能法案》的历史性进展

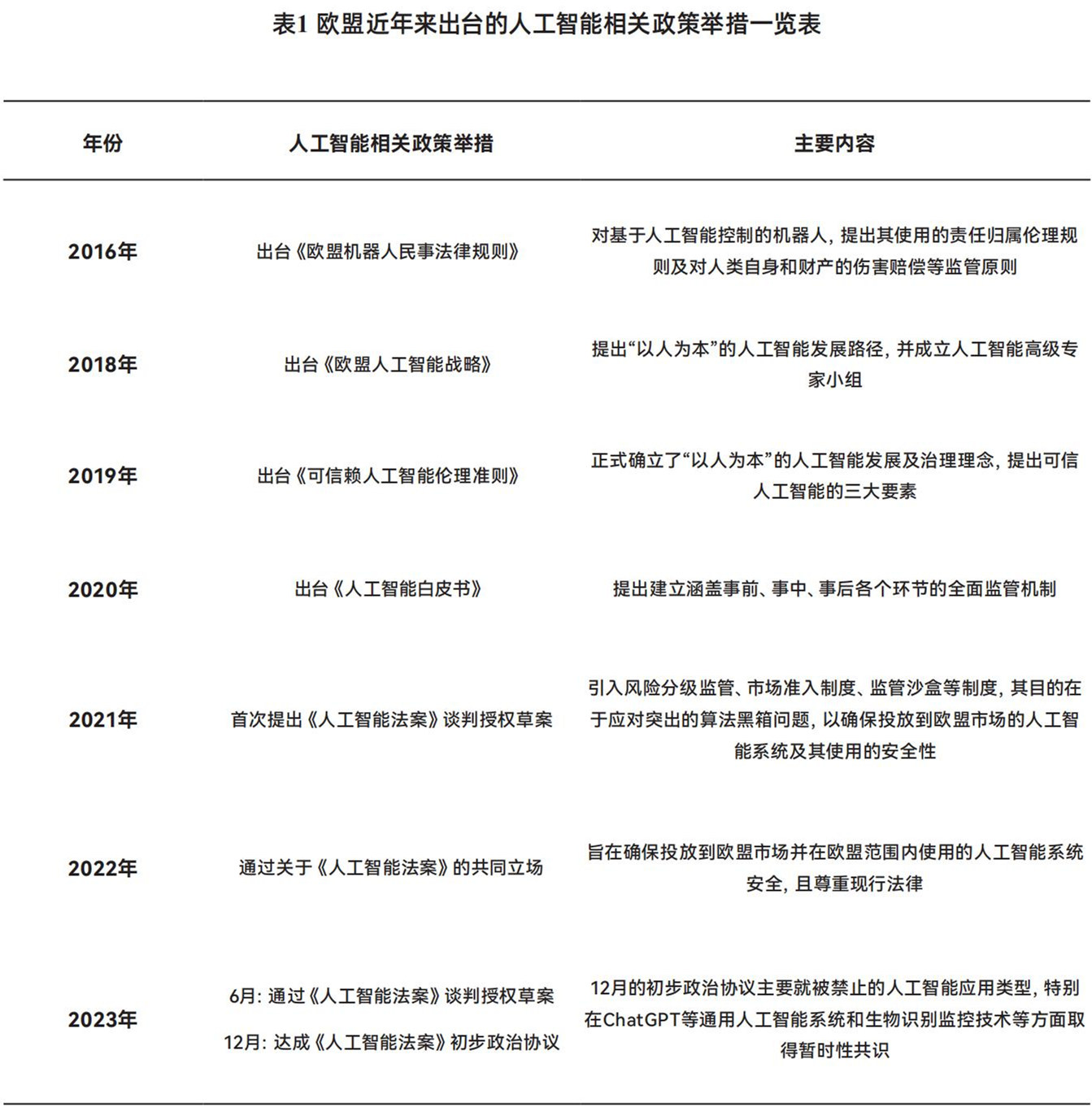

自2016年起,欧盟不断探索推进对人工智能技术应用的监管体系建构(表1),并于2021年开始逐步设计和推进《法案》的总体框架和具体细节。在2022年11月ChatGPT问世后,这一进程明显提速:2023年6月通过了《法案》谈判授权草案;12月9日,在经历了36个小时“马拉松式”谈判后,欧洲议会、欧盟委员会和27个成员国的谈判代表就欧盟《人工智能法案》达成历史性政治协议。本次协议的细节内容尚未公布,从欧洲议会和欧盟委员会发布的新闻稿内容看,重大进展主要包括四个方面。

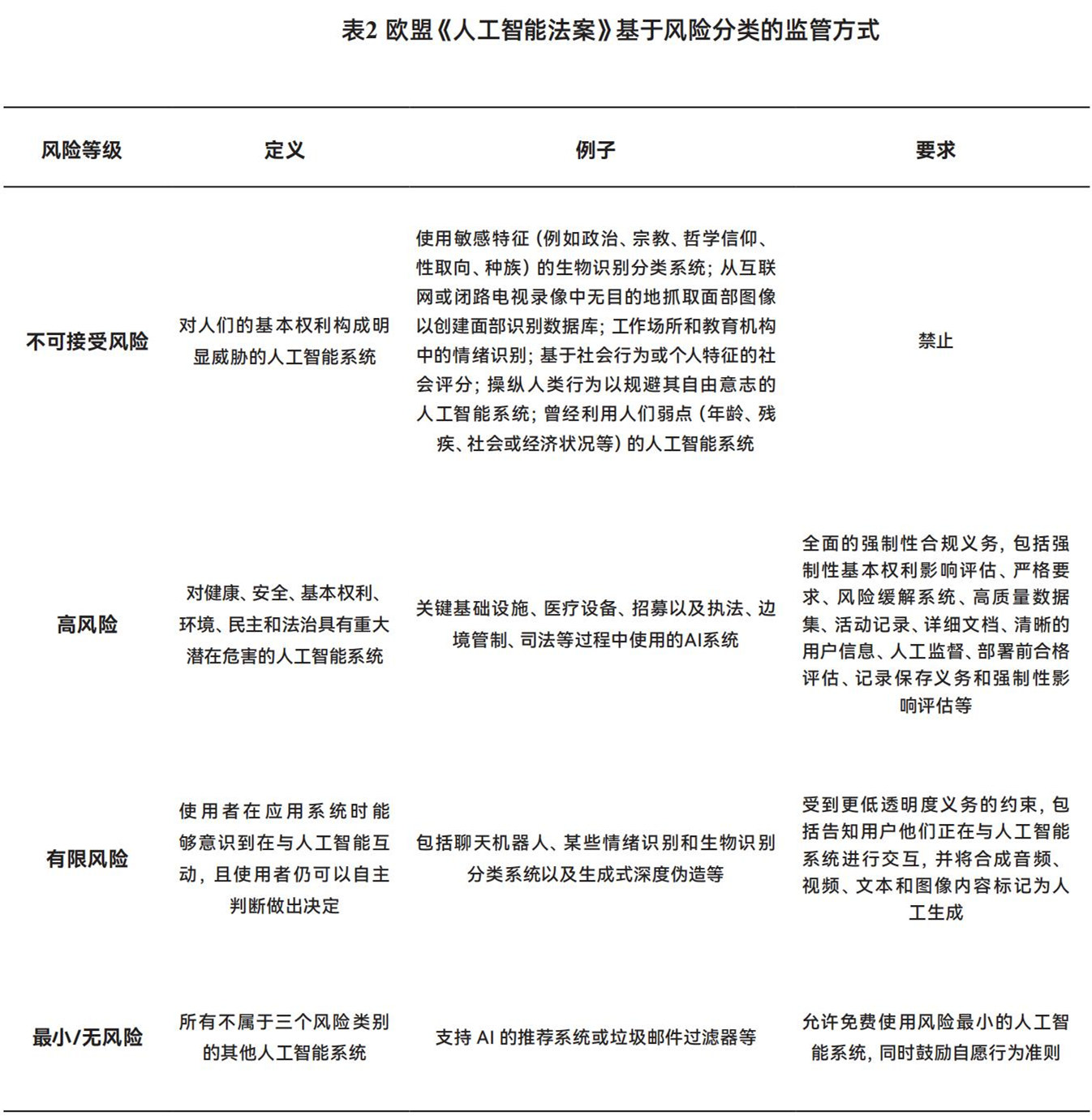

第一,巩固了基于风险分类的人工智能监管方法。此次协议首先明确了以经济合作与发展组织(OECD)制定的全球公认标准来界定“人工智能系统”,即“基于机器的系统,为了或明确或隐含的目标,通过其接收到的输入信息来生成诸如预测、内容、建议和决策等输出内容”,定义较2021年版本有所收窄。《法案》在沿用风险分类思路的基础上,将人工智能系统四个风险类别(不可接受风险、高风险、有限风险以及最小/无风险)中的不可接受风险和高风险两个类别进行了更为详尽的规定(表2)。在不可接受风险中,仅有一类应用可获得豁免,即执法机关利用相关技术打击犯罪,比如通过生物信息识别技术寻找被拐卖的儿童、捉拿重罪犯人等,这一情况在法院授权的情况下可被允许。

第二,取得了生物识别技术和通用人工智能模型(GPAI)监管的暂时性共识。对生物识别技术和通用人工智能模型(包括基础模型)监管的争论是本次谈判的焦点,欧盟试图将新的人工智能技术以及尚未开发的未来技术纳入立法范围。在生物识别技术方面,本次协议并未全面禁止,而是提出除非事先获得司法授权且针对特定犯罪,否则将禁止在公共场所使用远程生物识别(RBI)系统,即自动面部识别(AFR)系统;出于特定的执法目的,例如防止迫在眉睫的恐怖威胁或调查严重犯罪,该类技术的某些应用可能是允许的,但每种应用都受到严格的条件限制。在ChatGPT等通用人工智能模型方面,本次协议比起最初的提案新增了透明度要求和防护措施等内容。三方谈判的核心分歧是基础模型的监管方式,德、法、意在内的至少5个成员国认为,不应对基础模型施加任何监管,但最终为了达成本次协议而妥协。虽然大语言模型等基础模型本身并未被纳入“高风险”之中,但法案要求开发者对其透明度义务负责,这意味着开发者必须公布他们训练模型时使用的内容细节,确保遵守了欧盟的知识版权法律。此外,还引入了通用人工智能的防护措施,要求可能造成“系统性风险”的AI模型承担与管理风险和监控严重事件以及执行模型评估和对抗性测试相关的额外约束性义务。

第三,推出了人工智能监管沙盒等支持创新和中小企业的措施。由于2018年开始生效的欧盟《通用数据保护条例》对个人数据保护过于严苛,不利于创新发展。本次协议吸取经验,突破性提出采取沙盒措施,在人工智能系统开发和上市前阶段建立受控的实验和测试环境以促进创新,并进一步规范沙盒准入标准、申请程序、选择与退出沙盒以及参与沙盒各方的权利与义务等事宜,体现了技术监管的同时兼顾人工智能技术的发展和对个人基本权利的保障,一定程度上将降低初创企业和中小企业的进入门槛。

第四,明确了执法框架和部分处罚细节。本次协议提出:将在欧盟委员会内设置欧洲人工智能办公室这一新机构,承担各种行政、标准制定和执行任务,包括通用AI模型的新规则等;由欧盟成员国代表组成的欧洲人工智能委员会将继续作为协调平台和咨询机构服务于《法案》的实施;利益相关者咨询论坛将成立,为人工智能委员会提供技术专业知识。预计《法案》将主要通过各成员国的国家主管市场监督机构执行,违反《法案》可能会导致750万欧元到3500万欧元不等的罚款,具体金额取决于违规行为,但对中小企业和初创企业的行政罚款放宽了比例上限。

历史性协议达成的标杆意义

本次欧盟急于达成《人工智能法案》政治临时协议的主要原因有两方面:一方面,由于欧盟内部希望在2024年6月欧盟选举前完成相关立法的重要程序,以防止立法完全失效或推迟到2025年;另一方面,法国作为2024年奥运会的主办国,正在大力推动合法利用人工智能打击犯罪和恐怖主义。本次协议允许在《法案》通过后分阶段生效,包括禁止使用规则允许6个月,透明度和治理要求12个月,所有其他要求24个月。《法案》由欧盟官方发布后成为法律,所有条款将在未来两年内逐步生效,即全部法律效力可能要到2026年才能完全实现。本次协议的达成,更多意味着欧盟对人工智能监管和治理框架轮廓的逐步清晰。欧盟率先推出横向综合性人工智能监管和治理规则体系,体现了其试图引领塑造全球范围内的人工智能监管和治理共识、规则和标准的雄心,必将引发全球主要经济体在人工智能监管话语权和影响力的新一轮竞争。其标杆意义主要有三个方面。

第一,树立全球人工智能的横向立法标杆。近年来,欧盟放大数字经济立法领域“布鲁塞尔效应”(指欧盟通过其单方面的市场规制能力,在无需其他国家、协作的情况下,制定出全球市场遵循的规章制度。这种规则制定能力引领了全球商业环境的形成,导致全球商业许多重要方面的“欧洲化”)的趋势进一步增强。《法案》历史性协议达成,有助于欧盟进一步利用“布鲁塞尔效应”,对全球人工智能技术和产业发展产生直接影响。此外,欧盟《法案》的立法推进速度已明显早于美国国会,有助于欧盟通过联合国、G20和G7等多边合作平台,积极推广自身理念规则,增强该法案的国际影响力。《法案》采取了横向立法模式,即适用于所有投放于欧盟市场或者在欧盟可使用的人工智能系统,可以覆盖金融、医疗、教育、能源、运输、司法等各个行业领域,这与美国更加偏好的区分行业领域的垂直立法模式有着显著区别。作为全球第一个全面、横向且具有约束力的人工智能法规,不仅会改变欧洲人工智能行业的“游戏规则”,而且可能会大大增强全球跨司法管辖区域监管人工智能的势头。

第二,树立分类监管和保持弹性的监管标杆。《法案》采用风险分类分级的监管方法,在规定统一监管框架的基础上,识别和评估人工智能系统可能引发的风险,各类风险对应不同的应用场景和监管措施,基本涵盖了目前所有涉及的人工智能系统,有效避免了笼统规范化的合规义务带来的治理失焦问题,并为多种风险的复杂场景提供了较为清晰的解决思路。同时,采取动态调整的监管方式,允许监管机构将新的应用领域不断纳入现有的风险类别,既能够保持横向统一性和协调性,又能加快监管创新措施的落地实效。

第三,树立平衡创新与监管的路径标杆。本次协议试图同时达到将更广泛的人工智能技术纳入监管,以及促进产业和技术创新两方面目标。为了平衡监管与创新,本次协议提出鼓励中小企业技术创新的举措、设置新的监管机构,重视监管沙盒的规划和建设,并对部分情况进行豁免。比如,欧盟立法机构明确对人工智能的研发、对处理敏感特殊数据予以豁免等,体现立法过程中试图给技术创新更多的开放空间,尽可能减少规制的负面效应。

对我国平衡人工智能发展与监管的启示

本次达成的《法案》政治协议继承了欧盟利用规则兼顾人工智能可信可控和创新发展、着力维护欧盟技术主权的思路,相关规则与举措值得借鉴与参考。

第一,把握我国人工智能发展与监管的“平衡术”。建议找准我国人工智能科技创新与政策监管的平衡点,促进相关产业的合规健康发展。一方面,持续壮大国家战略科技力量,促进智能芯片、通用人工智能模型等关键核心技术攻关,积极推进大模型自主创新技术的成果转化和产业化应用,加快打造人工智能原创理论和技术的重要策源地。另一方面,可参考《法案》中算法透明度、通用人工智能护栏、禁止使用的场景划分等内容,根据我国人工智能产业发展特点,动态优化监管重点、豁免边界以及监管方式等。

第二,探索监管沙盒等“创新招”。西班牙、法国等欧盟国家已经开始人工智能技术监管沙盒试点,并与挪威、瑞士试点国家互通有无;新加坡推出人工智能验证(AI verify)工具包;IBM则开发使用人工智能情况说明(AI Factsheets)查看模型和部署详细信息,并实现商业化。这些均为国际前沿创新治理举措,已产生一定国际影响力。建议重视人工智能技术监管沙盒的整体谋划,在参考借鉴国际前沿实践的基础上,加强监管沙盒治理和治理措施的创新布局,妥善推动安全与创新发展。

第三,帮助企业筑起国际竞争的“护城河”。本次协议明确了域外适用原则,对非欧盟组织在欧盟市场上使用的人工智能产品或服务具有域外适用性,这不仅对欧盟成员国国内的产品应用和发展提出了明确的法律要求,也对非欧盟国家的企业在欧盟市场上的人工智能产品和服务产生影响。如《法案》生效通过,“长臂管辖”条款会促使其在全球层面上影响人工智能规则的制定。我国人工智能企业若要进入或维持在欧盟市场的业务,将面临该法案的合规挑战。特别是对于高风险AI系统,可能需要重大的技术和运营调整。建议主管部门及早梳理涉欧业务的人工智能企业清单,帮助企业及早应对。

——————

本文作者张苑为上海市科学学研究所高级经济师;陈秋萍为上海市科学学研究所助理研究员