谷歌CEO表示,谷歌最新的量子计算芯片Willow在基准测试中,在不到5分钟内完成了一项准计算,而超级计算机完成这项任务需要1025年。

谷歌的量子AI团队及其合作者开发出一种革命性的量子处理器Willow,它的错误率会随量子比特数增加而逐渐降低。这无疑是量子纠错领域的里程碑,因为它意味着,我们理论上可以无限地提高量子比特的质量,并最终无限提高量子计算机所能运行的算法的长度和复杂性。换句话说,量子计算机应当有能力运行人们梦寐以求的大型复杂算法。

噪声是所有物理系统(包括计算机)的固有特性。经典计算机中的比特通过冗余来避免噪声:一些数据保存于多个地方,如果出错,很容易识别和纠正。然而,量子力学的不可克隆定理规定,一旦测量量子态(这是复制量子态的第一步),量子态就会坍缩。

谷歌量子AI的研究员迈克尔 · 纽曼(Michael Newman)说道:“有一段时间,人们甚至惊讶于量子纠错这个概念还能存在。”

从20世纪90年代中期开始,信息理论家证明上述障碍并非不可逾越,几种用于纠正量子比特错误的代码也应运而生。所有这些代码背后的原理是,多个物理量子比特(例如超导电路中单个原子的电子状态,或者说能级)能够联网,以创建一个单独的逻辑量子比特,共同保存量子信息。

如此一来,就有可能使用“测量”量子比特来确定其中一个“数据”量子比特是否发生错误,与此同时又不影响后者状态。

纽曼解释道:“在量子纠错中,我们的重点就是追踪电子状态。发生什么错误了?即时搞清楚——然后当测量逻辑信息时,我们可以根据对错误的理解,重新解释测量结果。”

从理论上说,上述过程有可能帮我们实现“以无限稳定的量子比特执行无限长的计算”,但前提是错误率保持于足够低的水平。问题在于,每个新增的物理量子比特都会引入新错误源,因此,增加每个逻辑量子比特中的物理量子比特数量是把双刃剑。

逻辑量子比特的持续稳定性取决于几个因素,包括量子处理器(经典)软件检测和解释错误的能力,使用的特定纠错码,以及最关键的——物理量子比特本身的保真度。

2023年,纽曼和同事们展示了一种叫作“表面码”(surface code)的纠错码。纽曼称它有着“所有量子代码中最高的错误抑制因素之一”,通过向系统中添加更多物理量子比特,我们几乎就可以靠它搞定纠错这道难题。

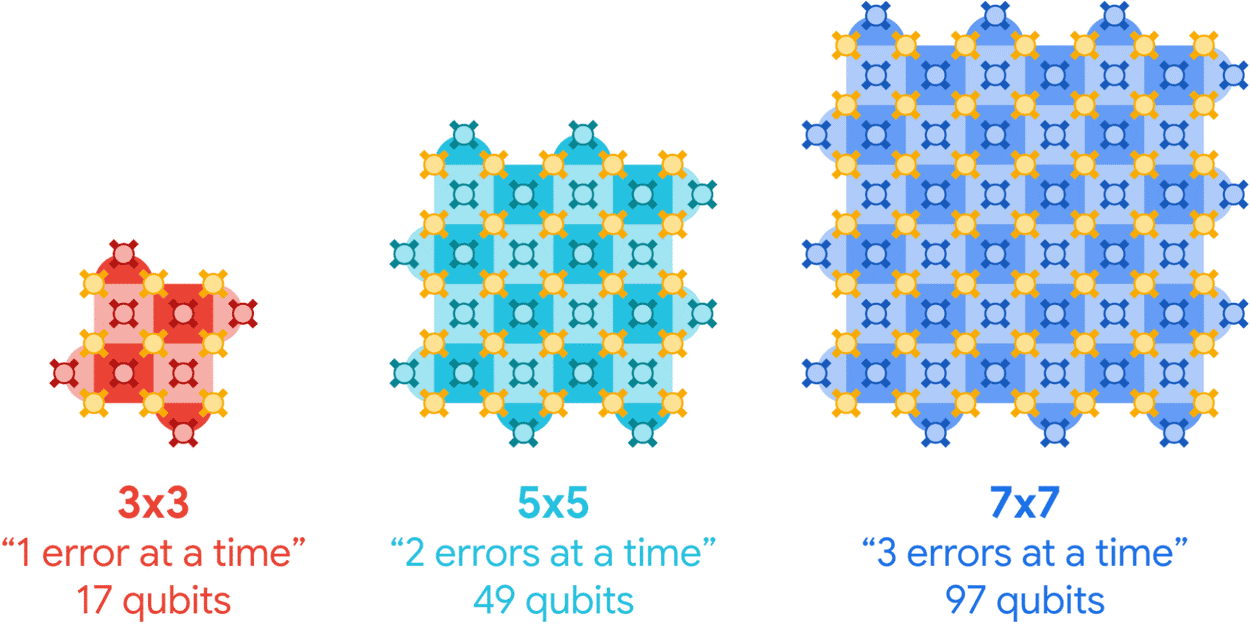

研究团队表明,由49个超导传输子量子比特(superconducting transmon qubit)组成的距离-5表面码,相较于由17个超导传输子量子比特组成的距离-3表面码,前者错误率会更低。这里的距离-3或距离-5表面码是指3×3或5×5的量子比特阵列,每个表面码代表一个单独的逻辑量子比特。

根据纽曼等人的思路,随着加入的物理量子比特数增加,量子比特阵列扩展,表面码距增大,编码错误率就降低。当然,量子AI团队不满足于5×5,又尝试了7×7……

在《自然》杂志于12月9日报道的新研究中,由哈特穆特 · 内文(Hartmut Neven)领衔的谷歌量子AI团队介绍了他们推出的新型超导处理器Willow。该处理器相比之前的Sycamore芯片有多项改进,包括逻辑门(逻辑运算的构建块)保持“量子性”(quantumness)的时间达到前者的5倍,以及Deepmind开发的机器学习算法具备实时解释错误的能力。

团队使用新技术在Willow——105量子比特处理器——上创建了九个距离-3表面码、四个距离-5码以及一个101量子比特的距离-7码,并发现每次扩展阵列,编码错误率就会以2.14的倍率降低。

如上图所示,随着表面码逻辑量子比特增大,量子处理器能够纠正更多错误。编码的量子态存储于数据量子比特阵列(黄色)上,测量量子比特(红色、青色、紫蓝色)能检查相邻数据量子比特上的错误。

纽曼表示:“这是我们第一次在增加物理量子比特数量的同时,看到逻辑量子比特中令人信服的指数级误差抑制。这是大约30年来,从业者们一直在努力追求的结果。”

有了可以连续数小时保持稳定的门电路,量子计算机应当有能力运行人们梦寐以求的大型复杂算法。

“当我们第一次按下Willow芯片上的按钮后,我看到阵列越来越大,错误率越来越低,我想——‘天呐!量子纠错真能起作用……量子计算可以玩儿得转!’”

资料来源:

Quantum processor enters unprecedented territory for error correction

END