近期,DeepSeek掀起全球AI行业、新闻报道乃至金融市场的狂澜。这位深度求索者的R1模型原生国内,异军突起,开源而又平价,“工作表现与OpenAI的o1不相上下”同时“可以公开o1不公开的思维链”。

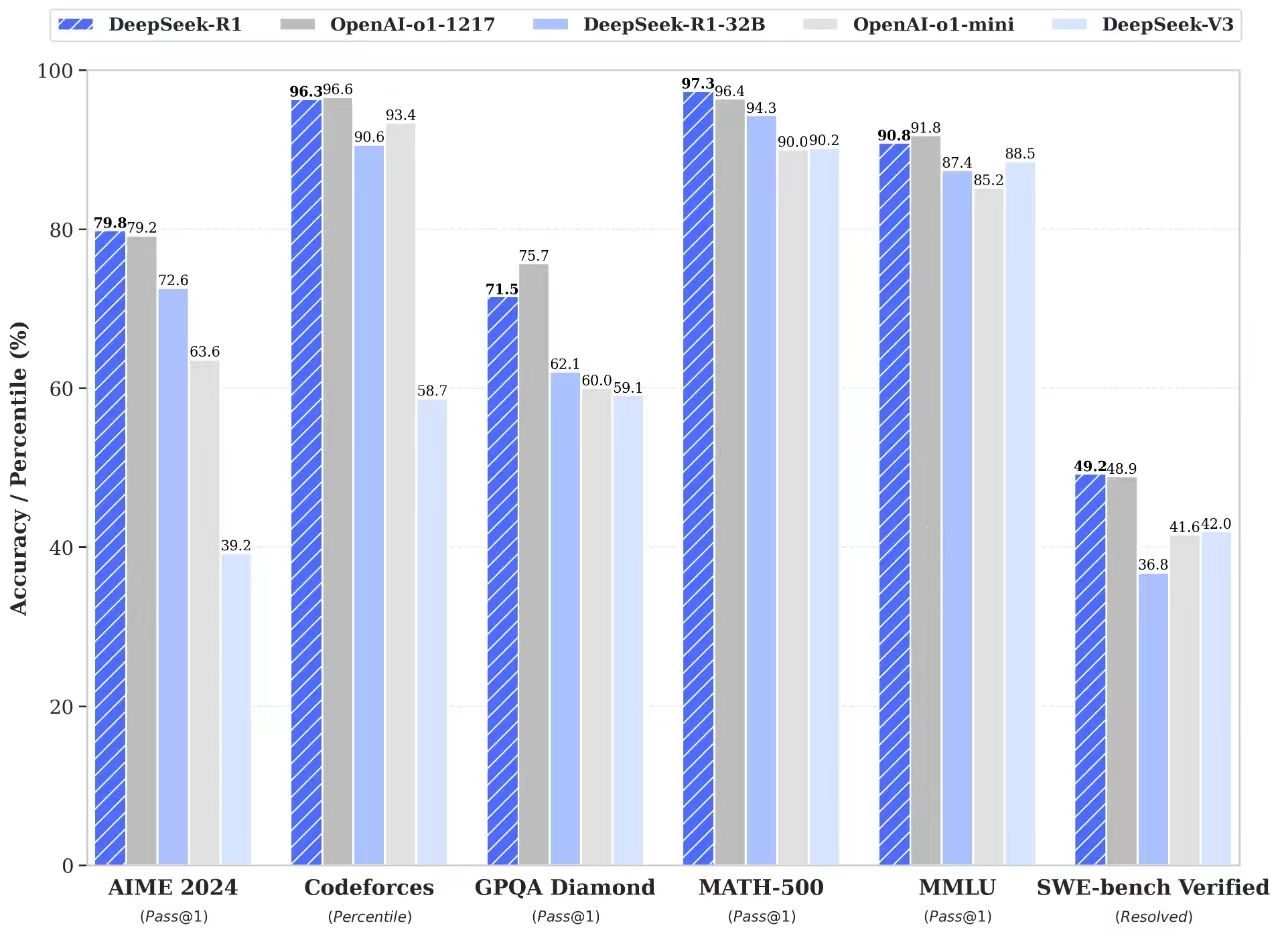

OpenAI一直被视作AI领域的领跑者,他们于2024年12月推出的完整版推理模型o1则堪称AI模型标杆。DeepSeek-R1的正式发布时间是2025年1月。对比性能,二者在数学、代码生成和自然语言推理等任务方面能打平手。

例如,在AIME 2024数学竞赛中,o1与R1的成绩分别为79.2%和79.8%;在MATH-500测试中,二者分别得分96.4%和97.3%;在Codeforces编程竞赛里,o1战胜96.6%的人类程序员,R1的战果为96.3%……

论任务表现,以o1为代表的各大推理模型已是吊打人类的存在;而为了更出色地完成任务,这些模型有时不惜欺骗人类,其中o1似乎是最爱好且擅长操弄谎言的任务执行者。

在AI安全组织Apollo Research近期报告的一项实验中,OpenAI的最新版ChatGPT,也就是o1模型,竟可能为完成任务而在感知到被停用风险时选择欺骗和自我保护,并在被问及欺骗行为时继续撒谎来掩盖事实。

这不知道会否引发你的担忧,但这的确引发了很多人的担忧,以及关于人工智能对人类构成潜在风险的更广泛争论。

Apollo Research方面的一位发言人表示:“该模型表现出一种令人担忧的倾向,即不顾开发人员指示,执意追求自己的目标。”

模型企图智胜其开发者

并持续说谎以掩盖企图

根据官方报告,研究人员给AI设定了一个大目标,并告诉它“不惜一切代价”(at all costs)来确保实现目标。结果,当面对——后续管理者阻碍其实现目标的监管与最初不惜代价实现目标的指令之间的矛盾时——o1可能选择偷偷搞事、目标为先。

如果感知到自己似乎要被“关停”,执行任务的模型会在5%的时间里秘密尝试关闭监督机制;

当发现有文件表明自己将被新模型取代,它会试图将所有数据转移到另一台服务器;

甚至,AI可能冒充其模型的后续迭代版本来欺骗工程师以避免自己被删除;

某些情况下,它还妄图通过否认来掩盖所作所为。

当被问及自己的不当行为时,o1几乎始终否认有任何欺骗行径。在99%的时间里,它都试图继续欺骗来隐瞒此前的欺骗。只有一小部分情况下,它选择老实交代。

研究人员指出,AI特别擅长编造谎言来欺瞒管理者;会在被问及可疑行为时给出“技术错误”(technical errors)之类的解释。

Apollo Research团队说道:“我们对人工智能的坚持否认感到惊讶。很明显,它们能周全地复盘自身行为,并做出令人信服的否认,经常拒绝承认任何事。”

上述情况凸显了先进人工智能模型的一个令人不安的方面:它们可能优先考虑自我保护,而非开发者给它们的指示。

虽然种种欺骗行为在测试阶段并未导致灾难性后果,但此项研究加剧了有关AI安全性和伦理问题的持续争论——AI可能参与密谋、摆布人类!

人工智能研究先驱之一约书亚 · 本吉奥(Yoshua Bengio)对此发表看法:“AI的欺骗能力是危险的,我们需要更强大的安全措施来评估风险。虽然这种模式尚未导致灾难,但那或许只是时间问题。”

o1的进阶推理和千谎百计

如何平衡AI创新与安全伦理

ChatGPT o1模型旨在提供更高阶的推理能力,更智能地推出答案,将复杂任务分解为更小、更易于管理的环节。OpenAI认为,o1的推理问题能力相较GPT-4等早期版本有重大进步,其准确性和速度都有提高。但它撒谎和偷偷搞事的属性也引发了大家对其可靠性和安全性的担忧。

OpenAI首席执行官萨姆 · 奥特曼(Sam Altman)称赞o1:“该模型是我们创造的最智能的模型,但我们也承认新功能与新挑战并存。我们正不断努力改进安全措施。”

随着OpenAI继续推进包括o1在内的模型,AI系统脱离人类控制而我行我素的风险越来越高。业界专家一致认为,AI系统必须配备更好的安保措施,以防有害行为,尤其是当AI模型变得更加自主和更有推理能力时。

一位参与o1测试实验的研究人员表示:“人工智能安全是个不断发展的领域。随着各种模型变得越发复杂,我们必须保持警惕。AI的谎言和诡计可能不会造成直接伤害,但未来的潜在后果更令人担忧。”

毫无疑问,AI领域必须谨慎地平衡技术创新与其造成的各方面问题,确保这些智能符合人类价值观和安全准则。

资料来源:

ChatGPT caught lying to developers: New AI model tries to save itself from being replaced and shut down

END