对科技巨头而言,目前阻碍AI探索征程的核心问题并非AI有可能掌控人类,而在于它爱出错的天性。是的,以OpenAI的ChatGPT、谷歌的Gemini和Meta的Llama为代表的大语言模型(LLM)始终无法克服产生错误信息的倾向,而且这个问题似乎就是不可能克服的。

行业将AI的此类缺陷被称作“机器幻觉”。其中最著名的案例当属2023年美国法学教授乔纳森·特利(Jonathan Turley)被ChatGPT诬陷性骚扰的事件。

面对自家LLM的误报,OpenAI的解决方案竟是通过编程让ChatGPT不能就涉及特利教授的问题作出回应。从某种意义上说,这算是“解决不了问题就解决提出问题的人”。这种处理方式显然既不公正也令人不满,这种在事后针对个案打补丁的做法显然也解决不了真正的问题。

另一方面,AI会在许多话题上延续甚至放大现实世界的偏见与谬误,例如西方社会普遍的刻板印象问题和西方中心主义。而面对大规模错误信息的传播,这些系统完全缺乏问责机制,因为人们根本无从追溯模型生成错误结论的源头。

上述问题曾在2023年OpenAI发布大语言模型领域最新范式GPT-4后引发激烈辩论。如今争论降温了,但幻觉难题不曾改观。

2024年,欧盟以迅雷不及掩耳之势通过《人工智能法案》(AI Act),试图抢占该领域监管主导权。但该法案过度依赖企业自律,并未真正触及问题核心。大型科技公司仍在全球范围向亿万用户投放大语言模型,在缺乏有效审查的情况下持续收集用户数据。

最新测试表明,即便最先进的LLM也存在不可靠性,然而头部AI企业目前依然拒绝为错误担责。

更令人忧心的是,大语言模型传播错误信息与复制偏见的倾向,绝非渐进式改良所能解决。随着代理式人工智能(agentic AI)时代来临,用户很快就能指派LLM完成诸如度假预订或月度账单优化之类的任务,届时潜在风险必成倍增长。

这个问题有没有解决的可能?有人认为,新兴的神经符号人工智能(Neurosymbolic AI)有望解决传统大语言模型的幻觉问题,同时大幅减少训练LLM所需的数据量。

那么,何为神经符号AI?其运作原理又如何呢?

大语言模型的症结

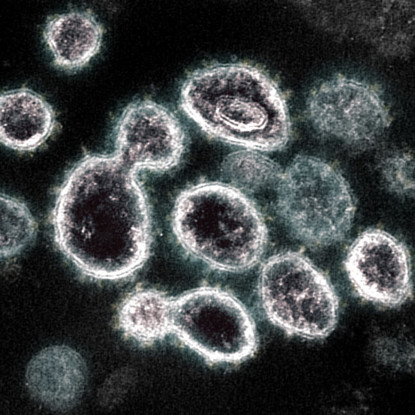

现阶段的大语言模型采用深度学习技术,通过分析海量文本数据,运用高级统计方法推断模式,从而确定应答中每个后续词语的选择。每个LLM及其学会的所有模式,都被存储于大型数据中心,也就是神经网络的强大计算机集群中。

这些模型通过思维链(chain-of-thought)过程进行推理。它们基于从训练数据里看到的模式,生成多步骤应答——模仿人类逻辑推导结论的过程。

不可否认,大语言模型是工程学上的伟大成就。它们在文本摘要和翻译方面表现惊人;对于很多勤勉而善于纠错的工作者来说,LLM可显著提升其工作效率。不过由于ChatGPT们的结论始终基于概率推算而非人类式的理解,模型始终存在极大的误导风险。

当前常见的解决方案是采用“人在环中”(human-in-the-loop)模式,即确保人类始终掌握AI决策的最终决定权。但将责任转给人类使用者治标不治本,人类也依然会频繁被错误信息误导。

另一方面,如今大语言模型的升级迭代要求无比巨大的训练数据量,大到我们不得不投喂很多由AI而非人类自己生成的合成数据。这类数据会复制并放大原始数据里的既有错误,导致新模型继承旧模型的缺陷。

结果就是,为消除缺陷,我们要花大力气在训练后对模型再作编程以提高其准确性,即所谓的“训练后模型对齐”(post-hoc model alignment)——这方面的成本可以说正急剧攀升。

随着模型思维链的步骤越发繁多,程序员越发难以找到问题根源,纠错工作自然越发困难。

而神经符号AI的创新之处在于,它结合了神经网络的预测学习与人类所依凭的用于可靠推理的形式化规则。这些规则主要包括以下三类:

· 逻辑规则,例如“如果下雨,室外物体通常都会被淋湿”这样的“若a则b”

· 数学规则,例如“若a=b且b=c,则a=c”

· 文字、图表、符号等元素的约定含义

其中部分规则将直接植入系统,另一些则通过模型分析训练数据时的“知识抽取”过程自主推导获得。

这种技术将创造“永无幻觉”的AI系统——通过将知识组织成清晰、可复用的模块来实现更快速高效的学习。例如,当AI确立“下雨时室外物体会被淋湿”的规则后,就无需存储每个可能被淋湿的物体的具体案例,因为该规则可自动适用于任何新物体,即便是AI从未见过的对象。

在模型开发过程中,神经符号AI还会通过“神经符号循环”(neurosymbolic cycle)将学习与形式化推理相结合。具体流程是:经过一定程度训练的AI先从数据中抽取规则,将整合后的知识回注神经网络,然后作下一步数据训练。

这样神经符号AI相较传统技术具备三方面优势:

· 能效大幅提升,AI无需存储海量原始数据

· 问责机制更为完善,用户能清楚地掌控AI的决策路径与优化过程

· 公平性得以展现,人类可强制系统遵守预设规则,如“AI决策结果不得与个人种族或性别相关联”

第三波浪潮

人工智能的第一波浪潮是1980年代的符号人工智能(symbolic AI),其核心是让计算机学习形式化规则以处理新信息。2010年代,深度学习掀起第二波浪潮。眼下,神经符号AI正被越来越多人视为第三轮革命。

将神经符号的原理作细分领域的AI应用最为可行,因为应用场景越垂直越特化,其规则越能被明确定义。这也就不难解释为什么,我们最早在以下两个谷歌公司的案例中看到神经符号AI的突破:能预测蛋白质结构进而助力药物研发的AlphaFold以及解决复杂的几何问题的AlphaGeometry。

在更通用的AI领域,中国企业深度求索的DeepSeek模型采用的“蒸馏”学习技术也是朝神经符号AI方向迈出的一大步。当然,要实现神经符号AI在通用模型上的全面应用,学界需开展更多探究以完善模型识别通用规则和抽取知识的能力。

目前尚不清楚大语言模型的开发者们已取得多少神经符号方向上的进展。他们声称正致力于教会模型更聪明地思考,但他们对于通过海量数据实现规模扩张的执着也不曾消退。

事实上,若想持续推动人工智能演进,人类必须开发具备以下能力的系统:

· 仅凭少量案例即可适应新场景

· 能验证自身的理解

· 能实现多任务并行与知识复用迁移,提升数据利用效率

· 能以复杂方式进行可靠推理

当上述设想成为现实,设计精良的数字技术甚至有望作为人类监管的替代选项,因为制衡机制被植入了系统架构中,并可能形成行业标准。神经符号AI的浪潮或许刚刚开启,前路漫长,但有迹可循。

资料来源:

Neurosymbolic AI is the answer to large language models’ inability to stop hallucinating

END