随着硬件设备的计算能力不断提升,深度学习在各个领域――从微型设备到大型数据中心――也将加速进步。

2016年3月,谷歌的计算机以巨大优势打败了世界围棋冠军李世石,这标志着人工智能发展的一个新里程碑。获胜的计算机程序由位于伦敦的谷歌下属DeepMind公司的研究者开发,它充分利用了所谓的深度学习机制,创建了一套人工神经网络。深度学习机制简单地说,就是模拟进行多层次任务处理的神经网络以自动运行的方式来处理手头的问题。

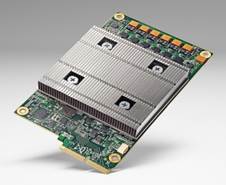

当时普通大众并不知晓的是,谷歌手头还有一张王牌。你要明白,谷歌用来打败李世石的计算机群含有一组专用硬件:谷歌把它称为张量处理单元。

谷歌硬件工程师诺姆·朱庇(Norm Juppi)在公司赢得围棋大赛两个月之后宣布了张量处理单元的存在,并在一篇博文中做了进一步的解释说明。谷歌已经在一年前为其数据中心配备这些新型加速卡。谷歌并没有详细地分享这些电路板上到底安装了什么硬件。很显然,它代表了加速深度学习计算的一个新的流行策略:使用了应用专有集成电路(ASIC)。

各家公司(主要是微软公司)采取的另一种策略则是使用现场可编程逻辑门阵列(FPGA)。它所带来的好处是:一旦计算要求发生变化,则阵列可以被重新设置。然而最普遍采用的方法是使用图形处理单元,即GPU,它可以平行处理许多数学操作。目前正在大力推广这种方法的是GPU制造商英伟达公司(Nvidia)。

确实,GPU领域的进步在2009年启动了人工神经网络的发展。当时,斯坦福大学的研究人员证实,GPU硬件能在合理的时间范围内培训深度神经网络。

“每个人都在进行深度学习的研究。”威廉姆·达利(William Dally)说。他目前领导着斯坦福大学的另一个深度学习研究组――VLSI建筑组,他同时还是英伟达公司的首席科学家。鉴于当前的发展,他认为,GPU技术是目前最好的选择。他这样讲并不奇怪,因为只要看看他的就职单位就明白了。

达利进一步解释说,有三个方向可供考虑。第一个方向是他所称的数据中心的培训。他指的是构建任何深度学习系统的第一步:调节神经元之间数以百万计的连接,以便让整个网络能完成所分配的任务。

为了构建这样的硬件体系,Nervana系统公司正在进行相应的开发,这家公司最近刚刚被英特尔公司收购。Nervana系统公司的计算机科学家斯考特·莱希曼(Scott Leishman)介绍,公司开发的ASIC深度学习加速器――Nervana引擎将于2017年上半年投入生产。莱希曼还提到,另外一种需要大量数学计算的工作――比特币挖矿――最开始使用CPU单元,然后转移到GPU单元,接着转移到FPGA技术,最后转移到ASIC技术上,首要原因就是这样的定制硬件可以大幅度提升能效、降低能耗。“深度学习领域也在发生着同样的变化。”他说。

深度学习硬件所承担的第二类而且也是一类比较特殊的工作是数据中心的推理任务,达利解释道。这里的推理是指云端人工神经网络不断进行的操作,它之前被训练用来完成许多工作。每天,谷歌的神经网络进行着指数级别的此类推理运算,例如对图像进行归类,对不同语言进行翻译,对口头词汇进行识别。尽管还无法断言,谷歌的张量处理单元很可能就是专为此类计算而生。

培训和推理很多时候需要不同的技能组合。通常,培训需要计算机能够以相对较高的精度进行计算,经常使用32位浮点计算。而对于推理来说,可以牺牲精度,让位于更快的运行速度或者更低的能量消耗。“这是研究的热点区域,”莱希曼说,“你的能量消耗到底能低到多少?”

尽管达利拒绝就英伟达公司的具体计划作进一步说明,他还是指出,公司的GPU技术已经在不断推进演化。英伟达公司早先的麦克斯韦尔架构可以进行双精度(64位)和单精度(32位)操作,而当前的帕斯卡架构能将运算能力提升到16位操作,相对于单精度运算,它能使运算通量和效率翻番。可以预见,英伟达公司未来将发布可以进行8位操作的GPU单元。这样的进展可以理想地应用于云端推理计算,从而能降低能耗、削减成本。

谷歌的张量处理单元加速其服务器上的深度学习计算

达利补充道,深度学习三驾马车中的最后一架是嵌入设备的推理运算,例如智能手机、照相机和平板电脑。这些运算应用的关键是低能耗的ASIC。未来几年,深度学习软件将在智能手机应用中发挥越来越重要的作用,例如,它当前已经被用于监测恶意程序或者翻译图像中的文字。

深度学习软件预计营收(单位:十亿美元)预计将很快超过十亿美元

无人机制造商大疆已经在其精灵4无人机产品上应用了与深度学习ASIC技术相类似的系统,后者使用了特殊的视觉处理芯片,这款芯片由位于加利福尼亚州的Movidius公司生产,它可以识别障碍物。Movidius公司是另一家最近刚刚被英特尔收购的神经网络公司。而高通公司则在其骁龙820处理器中集成了特殊电路,帮助实现深度学习计算。

尽管硬件设计能够加速深度神经网络的运行并带来一系列益处,但同时也存在着一个巨大的风险:如果技术进步足够快,则昨天设计的运行神经网络的芯片投入生产,制造出成品时可能已经成为明日黄花了。“算法的变革日新月异,”达利说,“每一个在此领域投入大量精力的公司都在进行一场赌博,希望能够早日收回投资。”

资料来源 IEEE Spectrum

责任编辑 遥 醒

_________________________

本文作者大卫·施奈德(David Schneider)是美国电子与电气工程师协会IEEE Spectrum高级编辑,哥伦比亚大学地质学博士。